Geschichte

Während vielen Jahren haben zuerst SOAP und dann REST APIs Einzug gehalten und die Strukturen und vor allem die Performance und Usability von professionellen WebApplikationen optimiert.

Die APIs können asynchron von der WebSeite gerufen werden und sobald ein Resultat da ist, kann es auf der Seite angezeigt werden.

Das hat uns ermöglicht, WebApplikationen zu bauen, welche fast wie eine Desktop-Applikation funktioniert. Die jedoch im Browser angesteuert werden kann und daher einem breiten Publikum zur Verfügung steht und auch viel einfacher Highly Available gemacht werden kann.

Problemstellung

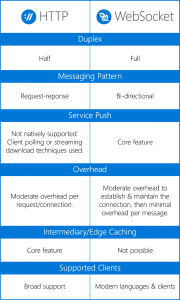

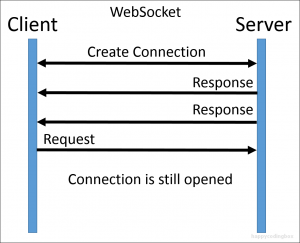

Es gab aber immer das Problem, dass die Schnittstelle nur ein-dimensional ist (get) und keine Server zu Browser Kommunikation erlaubt hat.

Wie oft haben Sie “polling” eingeführt, welches zu einer Unmenge von unnötigen Requests zum Server geführt hat?

Des Weiteren ist es auch nicht sonderlich produktiv, dass bei jedem API request eine neue HTTP connection aufgebaut werden muss.

Lösung

Die Lösung dafür heisst WebSockets.

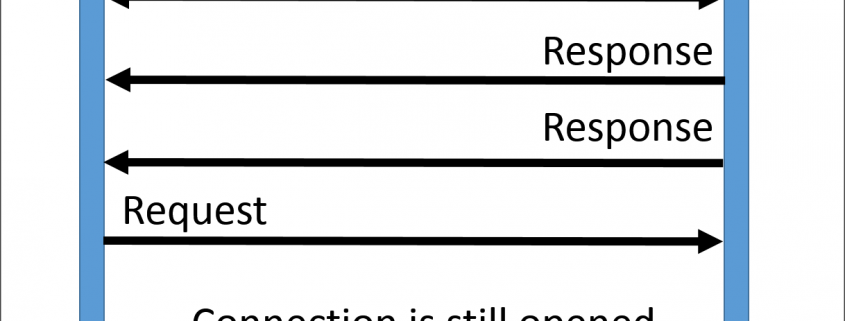

Damit kann man einen WebSocket Kanal öffnen, der zwischen dem Browser und dem Server bestehen bleibt. Danach kann man so viele Nachrichten durch den Kanal schicken, wie man möchte.

Und ja, man kann auch Informationen vom Server direkt zum Browser “pushen” – das Ende des Polling 🙂

Performance-Technisch hat sich erwiesen, dass die Verbindungen (vor allem bei höherer Anzahl) viel schneller sind und keine neuen connections aufgebaut werden müssen.

Interessiert? Kontaktieren Sie uns 🙂